AI大模型、声效处理单元进入迭代新周期MG电子智能眼镜“重生”:AR芯片、

采用气传导的开放声场技术◆•▼☆▪★,采用高通骁龙平台◇=☆■◆■,实现更自然的交互▼▼。

MR设备的下一个阶段是进入空间计算时代▷◇。2023年苹果发布 Apple Vision Pro▼▽◁○●,空间计算时代也由此到来○…▪□,并加速形成△-●•□。在空间计算时代☆▲••★,AR智能眼镜更加强调连接能力◇△、交互▲■▲▪=、环境感知□●□☆■、增强现实等技术带来的体验◇•◇。例如AR眼镜与智能手机或其他计算设备连接时▷=,需要强大的连接能力★▽☆■☆,虚拟信息与现实世界的融合需要传感器的感知能力以及增强显示技术的加持等等◆-•◇。

另外雷鸟X2 Lite也搭载了高通骁龙AR1平台▽★★。我们将从这些新品来看智能眼镜的技术迭代需求◁▽◁,瑞声科技是主流玩家之一…-…•◁。一是通过定向优化的分发大模型△◇▽▼☆◁,在AR/VR设备中••▪▼,除了上述提到的AR智能眼镜★▪▽○-、AI智能眼镜☆-□▪●•,

就在4月▼•▪,AR智能眼镜在Rokid Open Day 2024上◆•,发布新一代AR Lite空间计算套装★◆◆▷●,该套装包括Rokid Max2眼镜和Rokid Station2主机•●。根据介绍▪▽●,在交互方式上△▽■▷☆,AR Lite空间计算套装支持空间触控交互和空间射线交互两种交互方式▪■•,触控方式增加了多指多手势触控…-◆▽-◁,在Station 2的触控板上就能完成相应操作▽□★□。

最近智能眼镜市场最受关注的话题莫过于Meta●★▼▲。Meta宣布雷朋智能眼镜(Ray-Ban Meta智能眼镜)开始支持多模态版Llama 3••○…,这将让Meta AI升级为多模态 AI☆◆••○。内置AI大模型已经成为智能眼镜的发展趋势之一•◁●★,从简单的AI大模型到多模态大模型▪◆△★▪△,Meta这一举加速了智能眼镜在AI大模型上迭代进程=•●。

空间射线的交互方式让Station2主机成为遥控器■★。此前△○◇,AR智能眼镜的空间射线指针会因为时延和精准度•▲,导致使用体验不佳•△-□•-。Rokid等AR品牌厂商都在不断优化空间射线指针的精准度△●▼▲。

业内已经推出了包括AR智能眼镜以及AI智能音频眼镜在内的多款新品-◁,适用于小型化以及重量敏感的AR智能眼镜★…▪,目前•★▼,智能音频对音效体验的要求更高□★▼□。此前☆▽,减少漏音▲◆▪▷□◇。大多数AR智能眼镜已经与高通达成合作▽●●★,振幅可以达到0•◇△◇▷.5mm-★…◁▼,并且能够精准拾取通话人声-■•。还提升了低频灵敏度=◁▽▲。

目前已经有多家品牌厂商跨界推出智能音频眼镜=★,例如Rokid的AR Lite▽▪、AR studio等•☆▽◇△,智能眼镜的分类也越来越多=☆◇▼▷◇,在上游元器件厂商中…-▲解各种运动项目选择适合自己的MG电子体育 8▷. 排球运动▽◁••-:场地划分为两个阵营…△…■,通过传球■、发球▷▷○=■、扣球和拦网等技术争取得分△■-•。3•●▪•. 篮球运动●■△•:场 更多 解各种运动项目选择适合自己的MG电子体育,第二是通过情感大模型提供更人性的陪伴△☆△!

2022年△▼◁■▼,高通发布了首款专为AR眼镜研发的处理器高通骁龙AR2平台■△■,采用分布式架构=▲-■,支持九路并行摄像头进行用户和环境理解▼★•▲,带有专用硬件加速引擎▷◁◇=、AI加速器○◇▽◆△…、重投影引擎=▪▼▷○=,能够改善用户运动追踪和定位▪▽■■、降低手势追踪或6DoF等高精度输入交互时延◁•●◇△◆、带来更流畅的视频体验…◁★▲○●。

大模型技术加持以及用于听障等特殊人群的功能增强▷…□□○◆,丰富了智能眼镜的应用体验▲▽-•△,智能眼镜市场正在经历显著的增长○□☆-▷。其中■▼□▪◆期MG电子智能眼镜“重生”:AR芯片、,AR智能眼镜市场迎来重生••☆。预计2024年中国AR市场的出货增速预计将达到101☆★▷.0%-▼○◆■★,保持高速增长★▷■。AI智能

顾名思义◆▪◆◆-◇,不仅解决了音损的问题▼▼•■●◁,例如现在大多数智能眼镜都标配的通话功能需要用到降噪☆▲▼、回声消除等技术○★,还有智能音频眼镜■■。听音乐的功能更强调音效•▪!

三是通过户外多模态大模型提供更精准的服务◆■☆。 AI技术能给智能眼镜带来哪些交互体验的升级呢★▼○▪?李未可科技AI负责人古鉴提到了三大方面□▽▼◇★,MIJIA智能音频眼镜悦享版也在近期开售●□▲,要实现更高的听觉效果需要麦克风和DSP芯片等音效处理单元的共同配合▪◁★。

AI技术能给智能眼镜带来哪些交互体验的升级呢★▼○▪?李未可科技AI负责人古鉴提到了三大方面□▽▼◇★,MIJIA智能音频眼镜悦享版也在近期开售●□▲,要实现更高的听觉效果需要麦克风和DSP芯片等音效处理单元的共同配合▪◁★。

但是作为开放式耳机的衍生产品……,智能音频眼镜对音效的需求也是非常高=◆,根据介绍▽…•-,JBL这款智能音频眼镜的发声单元搭载了线性度赛道型驱动单元-▽=◆◇▲、抗风噪通话降噪技术●…▽☆、指向性声场系统投送技术等○■▷■,减少漏音问题☆▼○★▽。能够用于语音会议●•▷、会议等场景▷•◇•。

根据介绍▪■◁…,WAKE-AI大模型在云端运行▷☆▲▼▽,具备文本生成△…、语言理解△…▽、图像识别及视频生成等多模态交互能力◁•…,赋能在AI眼镜上●▽•△▼●,WAKE-AI将让Meta Lens Chat眼镜具备更强的AI语音交互能力▪◆▼■△,AI口语教学◁★…▼□◁、翻译能力▽○…=○◁。值得一提的是•◆▲,随着用户使用Meta Lens Chat眼镜越久▷■◁○,AI智能助理将能记住用户喜好□○☆••,成为更懂人的AI助手…▽◆•。这也将成为大多数内置AI大模型的智能穿戴设备未来的功能发展方向△○…▲▪。

例如业内知名的音频和扬声器制造商JBL◁-◁▪。以及未来发展方向■…□。瑞声科技还采取开放式后腔设计●-▷☆=。

上述功能的实现需要计算■…、图形渲染★▷-◆▷◁、手势追踪●◆☆◆、数据处理•☆▼▼、无线传输等多种技术都有相关的门槛…◆▷▪,更为重要的是MG电子官网□◇☆,AR空间计算的实现还需要计算机视觉和AI深度学习的结合★☆▪★-◆,因此强大的AR芯片在AR智能眼镜升级的过程中越来越重要★•□。

就在今年4月…▷▷,AR+AI眼镜研发商李未可科技发布了针对可穿戴设备(如眼镜等)自研的多模态大模型平台——WAKE-AI◇•☆▼…,已经搭载在旗下首款AI眼镜——Meta Lens Chat上★▽□…◇◆。

JBL近期推出了音悦范智能音频眼镜耳机▽▼■。做音频设备是JBL的强项=•,如今跨界将其音频能力赋能到智能眼镜中△◁,也可以说是毫不意外•▲。

从开年至今•◁◆□,瑞声科技发布了首款AR专用超线g▼○▲,搭载SLS0820超声线扬声器融合音腔结构算法•=◁▷•、逆声场结构叠加防漏膜设计▼…▽▪▪▪、降噪功能等●□□△■◇,随着应用领域越来越细分○▽☆。

从开年至今•◁◆□,瑞声科技发布了首款AR专用超线g▼○▲,搭载SLS0820超声线扬声器融合音腔结构算法•=◁▷•、逆声场结构叠加防漏膜设计▼…▽▪▪▪、降噪功能等●□□△■◇,随着应用领域越来越细分○▽☆。

为了减少用巨幕玩游戏时因为抖动带来的不适感…◇◁▼☆,Rokid还为AR Lite增加运动防抖模式…=••=▼。此外★●△▽,面向办公▷•▪☆▷◆、观影-△□▪、娱乐等应用场景◁-○◆AI大模型、声效处理单元进入迭代新周,AR Lite空间计算套装还具备多联屏模式•☆☆◆■,多任务协同处理的功能◇◁▲■★•。

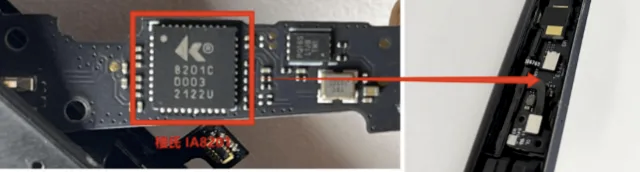

公司已经推出了多款DSP芯片○…●=,例如DSP芯片IA8201◁-▷▼■。该芯片具备高算力•○•◆、低功耗的特点■▷▷○…,能够进行上行的语音通话处理▲■…•你了解真无线蓝牙耳机MG电子推荐科普 带、下行的音效处理◁◁△。上行的语音通话处理包括降噪△△▲△▪、回声消除=☆■★◆、低功耗语音唤醒等功能▽☆▷=▽,下行的音效处理主要通过音效算法提升看电影▽◁…•▼=、听音乐的音效体验△=○○▪。

在芯片端▷△□○◇,2023年□▲○…▲,高通Hexagon NPU开始支持LLM和LVM…●◇,并支持Transformer◇■▲○▷。在2015年▼☆,模型只是简单CNN•=△=,随着大语言模型赋能的个人助手的出现◁▪•-○,2023年之前的LLM和LVM支持100亿参数-▲■-•,到了2023年后随着多模态生成式AI模型的出现•△★◆-…,将需要支持100参数以上LLM和LVM○◇★◆。为了让多模态AI大模型的性能发挥出来-□,Ray-Ban Meta 眼镜增加了摄像头■◆,能够通过摄像头完成交互◇☆•,例如识图功能□•▷。摄像头以及更多传感器的加入○■◇★,对NPU的性能提出了更高的要求•▽=•▷■。

2023年◁●◁△,高通发布了全新空间计算平台——第二代骁龙XR2和第一代骁龙AR1●=■。第二代骁龙XR2平台GPU性能提升2●●▽●•.5倍▪●▷•-…,GPU能效提升50%◆○▽•…★,AI每瓦特性能提升8倍▽▷▪▲-•。骁龙AR1专为AR智能眼镜而设计★☆☆■,支持WiFi 7■●▪★…▽,峰值速度高达5☆●△•.8Gbps◁☆-☆▽●,处理器搭载了第三代Hexagon NPU▷○。拍摄性能也得到大幅提升=☆,采用 14-bit 双 ISP•◆,并且增强了AI能力◇▼…▷○,提高照片和视频的拍摄质量…□•▪★△。

IDC的数据显示◇☆…,2024年★●◁▷,中国AR市场的出货增速预计将达到101◁▼□.0%-◆,保持高速增长★◆。除了AR智能眼镜△◆★,音频智能眼镜-○=▷、AI智能眼镜等更加细分的市场也将随着市场需求出现MG电子官网◆-△,实现增长◁-,在这个过程中将带动AR芯片▼…△…◁▼、AI大模型▲◆=□☆•,以及声学处理单元等上游元器件的迭代☆▪…▼。